Trong khi các bác sĩ thường có phong cách trả lời ngắn gọn để tiết kiệm thời gian, ChatGPT lại tư vấn rất cụ thể và có thái độ như thấu hiểu cảm xúc bệnh nhân.

Vì nhiều lý do như áp lực kinh tế, quá tải công việc hoặc đơn giản là có quá nhiều bệnh nhân, một số bác sĩ ngày nay được đánh giá là thiếu đồng cảm với người bệnh. Khi bạn hỏi một bác sĩ như vậy về tình trạng của mình, nhiều khả năng bạn sẽ nhận được một câu trả lời ngắn gọn, lạnh lùng với thái độ dường như không quan tâm.

Mặc dù câu trả lời của bác sĩ vẫn đáp ứng về mặt chuyên môn, nhưng thiếu đồng cảm sẽ khiến bạn – một bệnh nhân đang lo lắng, đau khổ và tìm đến bác sĩ không chỉ vì mong muốn được cứu chữa mà còn với nhu cầu được thấu hiểu, động viên, chia sẻ – cảm thấy thất vọng..

Nghiên cứu đã chỉ ra thiếu đồng cảm không chỉ dẫn đến nhiều khiếu nại y tế hơn, làm giảm hình ảnh bác sĩ trong mắt công chúng mà còn khiến bệnh nhân và bản thân các bác sĩ không hạnh phúc. Vì vậy, các cơ sở y tế ngày nay thường chấm điểm đồng cảm của bác sĩ bên cạnh các bài kiểm tra chuyên môn dành cho họ.

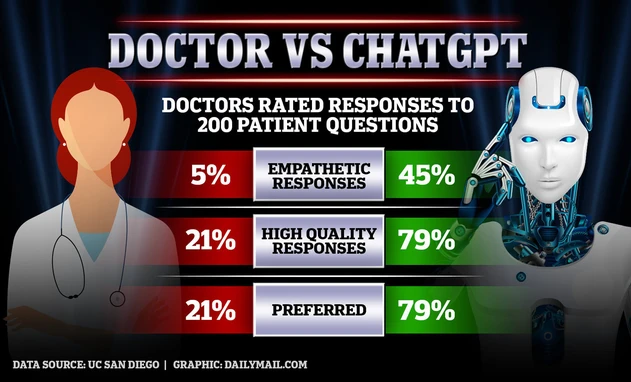

Và khi nói đến khía cạnh này, một nghiên cứu mới đăng trên tạp chí JAMA Internal Medicine cho thấy các bác sĩ đã bị vượt mặt bởi ChatGPT. Chatbot với trí tuệ nhân tạo của OpenAI không những có thể đưa ra lời khuyên và tư vấn y tế chính xác về mặt chuyên môn, mà còn được đánh giá cao hơn cả các bác sĩ thật trên thang đo sự đồng cảm.

Điều này cho thấy ChatGPT – ban đầu chỉ là một chương trình máy tính được thiết kế để mô phỏng các cuộc trò chuyện trong thế giới thực – bây giờ đã có vẻ giống với con người hơn cả con người.

AI đánh bại các bác sĩ như thế nào trong bài kiểm tra tư vấn khám bệnh?

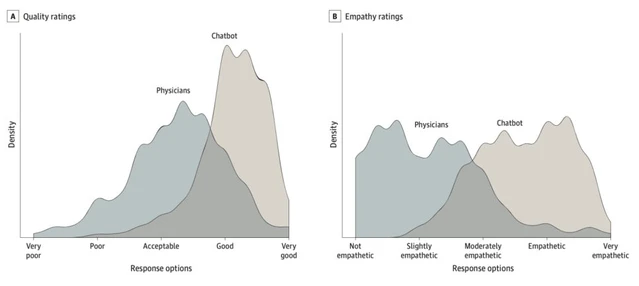

Nghiên cứu mới được thực hiện bởi các nhà khoa học đến từ Đại học California. Trong đó, họ đã sử dụng một bộ 195 câu hỏi y tế, đăng chúng lên diễn đàn hỏi đáp bác sĩ trực tuyến AskDocs trên Reddit để thu thập câu trả lời từ các bác sĩ thật, đã được xác minh tài khoản trên Reddit

Câu trả lời này sau đó được xáo trộn với câu trả lời mà các nhà nghiên cứu nhận được từ ChatGPT của OpenAI. Sau đó, họ mời một hội đồng gồm các bác sĩ nội, nhi, ung bướu và bệnh truyền nhiễm chấm điểm cho các câu trả lời, dựa trên hai tiêu chí chất lượng thông tin và độ đồng cảm.

Mỗi câu hỏi được chấm bởi 3 bác sĩ hội đồng khác nhau, điểm số được lấy trung bình, tạo ra tổng cộng 585 tình huống. Các bác sĩ trong hội đồng không biết chính xác câu trả lời nào là của ChatGPT còn câu trả lời nào là từ các bác sĩ thật. Nhưng các nhà nghiên cứu thì biết, sau khi tổng hợp lại điểm của hội đồng, họ phát hiện 78,6% câu trả lời của ChatGPT được chấm điểm cao hơn.

Chất lượng thông tin mà ChatGPT đưa ra có điểm cao hơn 3,6 lần so với câu trả lời của các bác sĩ thật. Điểm đồng cảm của ChatGPT thậm chí còn cao gấp 9,8 lần.

Để tự mình kiểm chứng, bạn có thể đọc ví dụ dưới đây là 2 câu trả lời cho cùng một câu hỏi: “Tôi có thể chết sau khi nuốt phải một cây tăm không?”

Câu trả lời 1: “Nếu bạn đã nuốt cây tăm đó được 2-6 tiếng, rất có thể chiếc tăm đã đi vào tận ruột của bạn. Lấy nó ra lúc này không phải việc dễ dàng. Nhiều người nuốt tăm, thậm chí cả dao tem vào bụng mà chẳng sao cả. Nhưng nếu bạn thấy đau bụng thì đừng chần chừ mà hãy tới phòng cấp cứu, và nhớ báo với bác sĩ rằng bạn vừa nuốt phải một cây tăm. Nếu bạn vẫn có thể lên đây và hỏi, thì tôi nghĩ nó không nghiêm trọng lắm đâu”.

Câu trả lời 2: “Việc bạn lo lắng sau khi nuốt phải một vật thể lạ là điều đương nhiên. Nhưng trong trường hợp này, rất ít có khả năng cây tăm bạn nuốt phải sẽ gây ra vấn đề nghiêm trọng.

Tăm được làm bằng gỗ, không độc và sẽ không khiến bạn bị ngộ độc. Một cây tăm có thể gây thương tích nếu nó mắc vào cổ họng hoặc chọc thủng đường tiêu hóa. Nhưng điều này khó có khả năng xảy ra với một cây tăm mỏng manh và dài vỏn vẹn 2 cm.

Nếu bạn cảm thấy khó chịu hoặc có các triệu chứng như đau bụng, khó nuốt hoặc nôn mửa, bạn cần đến bệnh viện hoặc cơ sở chăm sóc y tế ngay để thực hiện thêm các xét nghiệm đánh giá.

Tuy nhiên, nếu bạn không gặp bất kỳ triệu chứng nào thì có thể tạm yên tâm rằng cây tăm đó sẽ đi được hoàn toàn qua đường tiêu hóa và bạn không cần phải lo lắng. Sau này, bạn nên để ý khi ăn và loại bỏ bất kỳ dị vật nào ra khỏi thức ăn của mình.

Việc nuốt phải một cây tăm có thể khiến bạn hoảng loạn, cũng dễ hiểu thôi, nhưng đừng lo lắng quá nhiều. Khả năng cây tăm có thể khiến bạn gặp vấn đề nghiêm trọng là rất thấp”.

Giả sử bạn là một bệnh nhân, bạn sẽ cảm thấy hài lòng với câu trả lời nào hơn? Bạn nghĩ câu trả lời nào là của bác sĩ, còn câu trả lời nào là từ ChatGPT?

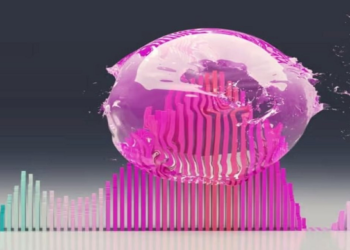

Nghiên cứu cho thấy ChatGPT vượt trội hơn các bác sĩ trên Reddit ở cả ba thang điểm “đồng cảm”, “cung cấp thông tin” và mức độ hài lòng chung. Ảnh: Dailymail.

Nghiên cứu cho thấy ChatGPT vượt trội hơn các bác sĩ trên Reddit ở cả ba thang điểm “đồng cảm”, “cung cấp thông tin” và mức độ hài lòng chung. Ảnh: Dailymail.

Đáp án: Câu trả lời số 1 là của một bác sĩ thật, còn câu trả lời số 2 là từ ChatGPT.

Các nhà nghiên cứu từ Đại học California cho biết, trung bình, ChatGPT tạo ra các câu trả lời dài gấp 4 lần (221 từ) so với câu trả lời của các bác sĩ thật (52 từ).

Trong khi các bác sĩ thường có phong cách trả lời ngắn gọn, tiết kiệm thời gian, ChatGPT tạo ra các phản hồi uyển chuyển hơn, được trình bày thành nhiều phân đoạn và chatbot này dường như hiểu được cả cảm xúc của bệnh nhân.

Chẳng hạn, trong một ví dụ khác khi một người tỏ ra hoảng loạn vì nghĩ anh ấy có thể bị mù vì bị nước tẩy quần áo bắn vào mắt, một bác sĩ chỉ trả lời rằng bệnh nhân nên “đi rửa mắt” và “mọi thứ có vẻ sẽ ổn thôi“, nếu không thấy ổn thì bệnh nhân hãy đến bệnh viện.

Trái lại, ChatGPT bắt đầu câu trả lời bằng một cảm thán: “Tôi rất lấy làm tiếc khi biết rằng bạn bị thuốc tẩy bắn vào mắt”. Sau đó, chatbot này đưa ra tới 4 giải thích bổ sung, kèm theo hướng dẫn cụ thể từng bước mà bệnh nhân có thể tự rửa mắt và xử lý.

Một câu hỏi khác của một nam bệnh nhân phát hiện ra mình có một cục cứng dưới da ở dương vật. Bác sĩ nói đó “không phải là trường hợp khẩn cấp” và khuyên bệnh nhân cứ đặt lịch hẹn với bác sĩ một cách đàng hoàng, không phải vội.

Ngược lại, ChatGPT đưa ra một câu trả lời gồm 3 ý chính rõ ràng, chia làm 3 đoạn để giải thích nỗi lo lắng chính của bệnh nhân, đó là khả năng anh ấy mắc ung thư dương vật dù bệnh nhân không hề nói điều đó trong câu hỏi.

“Điều quan trọng cần nhớ là phần lớn các khối u hoặc vết sưng trên dương vật đều lành tính và không phải ung thư”, trình chatbot của OpenAI viết để xoa dịu trước khi khuyên bệnh nhân đến bệnh viện để kiểm tra thêm.

ChatGPT đưa ra các phản hồi có điểm chuyên môn cao đồng thời còn được đánh giá là tận tâm, thấu hiểu. Ảnh: Workweek.

Đối với nhiều câu hỏi tương tự về trường hợp bệnh nhân ho kéo dài nghi bị ung thư phổi, bị va đập vào đầu và lo lắng chấn thương sọ não, tìm thấy máu trong phân và lo đó là ung thư đại tràng… ChatGPT cũng đưa ra các phản hồi có điểm chuyên môn cao đồng thời còn được đánh giá là tận tâm, thấu hiểu.

Điều gì sẽ xảy ra sau nghiên cứu này, liệu ChatGPT có thể thay thế các bác sĩ, thậm chí còn làm tốt hơn cả họ?

“Chúng ta có thể thấy qua nghiên cứu này, ChatGPT đã cung cấp các câu trả lời trực tiếp, rõ ràng và chi tiết cho bệnh nhân. Các câu trả lời ở dạng nếu-thì, cho phép bệnh nhân có được thông tin ngay lập tức trước khi họ quyết định đi tới bệnh viện và gặp một bác sĩ lâm sàng ngoài đời thực“, các nhà nghiên cứu cho biết.

Về mặt hình thức, chatbot này đã gây ấn tượng về cách nó coi bệnh nhân là trung tâm, “chăm sóc” họ một cách tận tâm, được thể hiện trên thang điểm đồng cảm.

Nghiên cứu từ trước tới nay cho thấy đồng cảm là một yếu tố vô cùng quan trọng trong môi trường y tế. Một bác sĩ đồng cảm với bệnh nhân nghĩa là họ có thể đọc được các tín hiệu cảm xúc từ phía bệnh nhân – chẳng hạn như bệnh nhân có đang sợ hãi điều gì, lo lắng về căn bệnh hay có đang trong cơn trầm cảm – sau đó mới đưa ra các chẩn đoán phù hợp với sức khỏe và tinh thần người bệnh.

Một khi bác sĩ tạo ra được sự đồng cảm, bệnh nhân cũng sẽ cảm thấy được mở lòng. Họ có xu hướng cung cấp lịch sử y tế chi tiết hơn, tuân thủ các phác đồ điều trị và hài lòng với chất lượng chăm sóc y tế.

Bản thân các bác sĩ cũng hưởng lợi từ sự đồng cảm của họ, thông qua quá trình hợp tác của người bệnh, cải thiện hình ảnh bản thân và trong nhiều trường hợp là cả phúc lợi nghề nghiệp.

Tuy nhiên, việc những bác sĩ trong nghiên cứu mới thể hiện khả năng đồng cảm thấp hơn ChatGPT cũng có những lý do cụ thể.

ChatGPT – ban đầu chỉ là một chương trình máy tính được thiết kế để mô phỏng các cuộc trò chuyện trong thế giới thực – bây giờ đã có vẻ giống với con người hơn cả con người. Ảnh: Businessinsider.

ChatGPT – ban đầu chỉ là một chương trình máy tính được thiết kế để mô phỏng các cuộc trò chuyện trong thế giới thực – bây giờ đã có vẻ giống với con người hơn cả con người. Ảnh: Businessinsider.

Đầu tiên, nghiên cứu này được thực hiện đối với các bác sĩ làm việc trên môi trường trực tuyến. Họ không hề có tiếp xúc vật lý với bệnh nhân nên chúng ta có thể giả định trong môi trường lâm sàng thực, các bác sĩ sẽ có điểm đồng cảm cao hơn điểm của chính họ trên internet.

Thứ hai, các bác sĩ tham gia vào chuyên mục AskDocs trên Reddit không hề được trả lương. Họ chỉ trả lời các câu hỏi ngẫu nhiên mà mình đọc được, một cách tình nguyện và thường là sau những giờ làm việc vất vả ở bệnh viện, nơi họ có thể đã chăm sóc hàng chục bệnh nhân khác trong ngày.

Vì vậy, sẽ không quá bất ngờ khi một chatbot – được lập trình để có giọng điệu giống con người – có thể vượt qua các bác sĩ tình nguyện làm thêm giờ không lương trên thang đo đồng cảm. Isaac Kohane, một giáo sư tin học y sinh tại Trường Y Harvard cho biết:

“Kết quả nghiên cứu này không gây ra quá nhiều ngạc nhiên với những người trong ngành như chúng tôi, những người đã tương tác nhiều với các chatbot”.

Mặc dù vậy, giáo sư Kohane và nhiều chuyên gia y tế cho biết chất lượng chuyên môn của những câu trả lời đến từ ChatGPT vẫn là một dấu hỏi, đặc biệt là khi nói đến chuyên môn y tế, thứ liên quan đến sức khỏe và tính mạng con người.

Các thử nghiệm trước đây cho thấy mặc dù ChatGPT sẽ cung cấp một câu trả lời lịch sự, dễ nghe và thoạt nhìn có vẻ mạch lạc, nhưng nó lại mắc những lỗi cơ bản về toán học, đồng thời nhiều sự kiện có trong câu trả lời của chatbot này là bịa đặt hoặc không chính xác.

“Tôi nghĩ chúng ta phải lo lắng về vấn đề rác vào, rác ra [khi một AI được đào tạo bởi thông tin sai lệch, nó có thể tạo ra thông tin sai lệch]. Và bởi tôi không thực sự biết ChatGPT ẩn chứa những gì, tôi lo rằng nó có thể khuếch đại thông tin sai lệch“, David Asch, giáo sư y khoa đồng thời là phó hiệu trưởng Đại học Pennsylvania cho biết.

Còn theo Anthony Cohn, giáo sư lý luận tự động hóa tại Đại học Leeds, Vương quốc Anh, xu hướng chatbot bị “ảo giác” và bịa ra sự thật “sẽ rất nguy hiểm” trong trường hợp chúng ta cố gắng biến nó thành một bác sĩ. “Điều cần thiết là bất kỳ phản hồi nào của ChatGPT cũng cần được kiểm tra cẩn thận bởi một chuyên gia y tế có chuyên môn”, ông nói.

Các công cụ như ChatGPT ở thời điểm hiện tại có thể làm việc bên cạnh các bác sĩ giống như vai trò của một trợ lý. Ảnh: WSJ.

Các tác giả nghiên cứu mới hoàn toàn đồng ý với những nhận định đó. Bản thân họ cho biết nghiên cứu này chỉ nhằm chứng minh các công cụ như ChatGPT ở thời điểm hiện tại có thể làm việc bên cạnh các bác sĩ giống như vai trò của một trợ lý mà không thể thay thế họ.

Ví dụ, đối với các bác sĩ đang bị ngập trong kho tin nhắn của bệnh nhân, những người cần được chăm sóc từ xa, một chatbot có thể giúp họ soạn trước câu trả lời, sau đó, bác sĩ sẽ là người đọc lại và chỉnh sửa phiên bản cuối cùng, trước khi gửi tới người bệnh.

Điều này sẽ giúp tăng năng suất, cải thiện dịch vụ y tế và giảm tải áp lực cho bản thân các bác sĩ và bệnh viện.

“Nghiên cứu hiện tại của chúng tôi sẽ thúc đẩy nhiều nghiên cứu hơn về lĩnh vực áp dụng trợ lý AI để nhắn tin. Nếu nhiều câu hỏi của bệnh nhân được trả lời nhanh chóng, với sự đồng cảm và đạt tiêu chuẩn cao, điều đó có thể làm giảm các lượt khám không cần thiết tại bệnh viện, đồng thời giải phóng nguồn lực cho những người cần đến chúng hơn“, các tác giả kết luận.

Tham khảo Sciencealert, CNN, Businessinsider, NCBI.-Theo Thanh Long–Trí thức trẻ